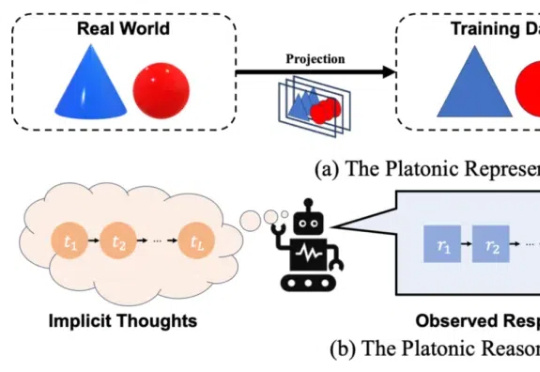

人大刘勇团队「慢思考」机理分析:从雪球误差到正确推理概率

人大刘勇团队「慢思考」机理分析:从雪球误差到正确推理概率「慢思考」(Slow-Thinking),也被称为测试时扩展(Test-Time Scaling),成为提升 LLM 推理能力的新方向。近年来,OpenAI 的 o1 [4]、DeepSeek 的 R1 [5] 以及 Qwen 的 QwQ [6] 等顶尖推理大模型的发布,进一步印证了推理过程的扩展是优化 LLM 逻辑能力的有效路径。

「慢思考」(Slow-Thinking),也被称为测试时扩展(Test-Time Scaling),成为提升 LLM 推理能力的新方向。近年来,OpenAI 的 o1 [4]、DeepSeek 的 R1 [5] 以及 Qwen 的 QwQ [6] 等顶尖推理大模型的发布,进一步印证了推理过程的扩展是优化 LLM 逻辑能力的有效路径。

新年伊始,在估值攀上 3400 亿美元的新巅峰后,OpenAI 也辞旧迎新,更换了新字体、新标志、新配色方案,进行了一次全面的品牌重塑。Open AI 这次重塑的目的,一是为了摆脱设计总监 Shannon Jager 所说的「OpenAI 一直在用相当随意的方式,向世界展示自己。字体、Logo 和颜色的杂乱无章,只会彰显出公司缺乏明确的统一战略。」

DeepSeek 的最新模型 DeepSeek-V3 和 DeepSeek-R1 都属于 MoE(混合专家)架构,并在开源世界产生了较大的影响力。特别是 2025 年 1 月开源的 DeepSeek-R1,模型性能可挑战 OpenAI 闭源的 o1 模型。

刚刚,腾讯云再放大招——不仅上线了 DeepSeek-R1 和 V3 原版模型的 API 接口,还将它们接入了大模型知识引擎,并支持联网搜索,成为国内率先实现这一能力的云厂商。

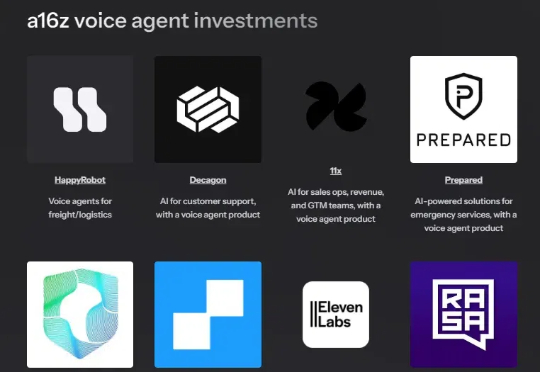

语音是人工智能应用公司最重大的突破之一。作为人类最常用、信息密度最高的交流方式,语音如今在人工智能的推动下首次实现了“可编程化”。

DeepSeek的V3模型仅用557.6万的训练成本,实现了与OpenAI O1推理模型相近的性能,这在全球范围内引发连锁反应。由于不用那么先进的英伟达芯片就能实现AI能力的飞跃,英伟达在1月27日一天跌幅高达17%,市值一度蒸发6000亿美元。

在整个春节期间,DeepSeek的一夜爆火令人印象深刻,无论公域还是私域场合都随处听到讨论它的声音。而我们注意到其开发商杭州深度求索人工智能基础技术研究有限公司是一家成立仅一年半的新公司 (背后的量化私募公司运营时间较久) 。

适应性是自然界最引人注目的现象之一。从章鱼改变皮肤颜色以融入周围环境的方式,到人类 大脑在受伤后如何自我重塑,使个体能够恢复失去的功能并适应新的思维或运动方式。生物体表现出适应性,使生命能够在多样化和不断变化的环境中蓬勃发展。

最新消息 OpenAI 本周宣布计划向加州州立大学 23 个校区的 46 万名学生和 6.3 万名教职员工推出ChatGPT。这款以教育为重点的人工智能助手,旨在为学生提供个性化的辅导和学习指南,而教师则可以使用它来完成行政工作。

A 股蛇年首个交易日,DeepSeek 概念股上演涨停潮,AI 主题基金净值也水涨船高。2 月 6 日,A 股三大指数低开高走,截至午间休盘,全部翻红。